Du concept à la vidéo cinématographique : la puissance de l'IA full stack dans la génération vidéo

Full Stack AI est une plateforme d'intelligence artificielle de bout en bout conçue pour aider les entreprises et les équipes à déployer, gérer et exploiter l'IA dans divers contextes réels. Elle couvre l'ensemble de la chaîne de valeur, depuis l'infrastructure GPU haute performance jusqu'aux modèles d'IA spécialisés, en passant par les outils d'orchestration, les workflows personnalisables et les interfaces métier, le tout dans un environnement privé et souverain.

Cette approche permet une grande variété de cas d'utilisation : assistants commerciaux augmentés, génération augmentée par la récupération (RAG), automatisation des processus, création et analyse de contenu, ou production visuelle avancée. L'IA Full Stack ne se limite pas à un seul format ou domaine ; elle s'adapte aux besoins spécifiques de chaque organisation tout en offrant des niveaux élevés de contrôle, de sécurité et de puissance de calcul.

La création vidéo est un exemple parmi d'autres de ce que cette pile complète peut accomplir. Appliquée à l'industrie des médias, elle démontre la capacité de la plateforme à orchestrer des flux de travail complexes qui exigent précision, cohérence visuelle et puissance de calcul élevée, tout en garantissant la pleine propriété et les droits d'auteur sur vos productions.

Dans ce guide, nous nous concentrons sur ce cas d'utilisation particulier, la vidéo, à travers un exemple concret. Vous découvrirez comment tirer parti de la plateforme Full Stack AI pour exécuter un workflow complet de production d'un court métrage cinématographique, en combinant Flux Kontext pour la cohérence des personnages et WAN 2.2 pour le mouvement, le tout accéléré par un cluster GPU Nvidia H200 privé.

Ce tutoriel vidéo de 10 minutes montre exactement comment passer d'une page blanche à un rendu cinématographique 4K époustouflant.

📺 Regardez le flux de travail en action

Découvrez comment nous avons créé le court métrage « Countryside Train Ride » à l'aide de la plateforme Full Stack AI fonctionnant sur des clusters GPU de niveau entreprise.

Le processus technique en 5 étapes

Ce tutoriel explique la méthodologie utilisée pour créer un court métrage professionnel sans équipe de tournage, sans acteurs et sans décor.

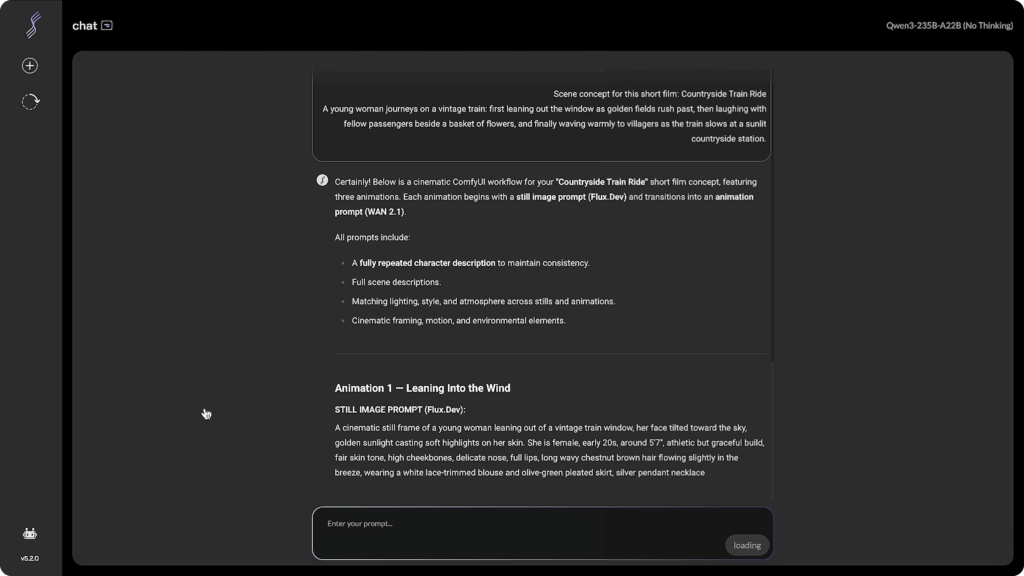

Étape 1 : Structuration du plan directeur (module de chat)

Chaque vidéo commence par une invite structurée. Nous utilisons le module Chat de la plateforme (intégré à RAG et aux fonctionnalités de recherche Web) pour réfléchir et affiner le script.

La stratégie : nous demandons à l'IA de générer une description de la scène qui inclut des détails spécifiques sur l'éclairage (« heure dorée », « éclairage volumétrique »), la configuration de l'appareil photo (« objectif 35 mm », « bokeh ») et l'environnement.

La clé de la cohérence : nous veillons à ce que chaque scène contienne exactement le même bloc de description des personnages. Ce texte agit comme l'« ADN » du film, garantissant que l'apparence du protagoniste (couleur des cheveux, vêtements ou traits du visage) ne change pas d'un plan à l'autre.

🦎Conseil Iguana : Créez une « fiche personnage ». » Avant d'écrire vos scènes, rédigez une description de 50 mots de votre personnage (par exemple, « Une jeune femme, la vingtaine, peau mate, cheveux bruns ondulés, vêtue d'un chemisier blanc vintage »). Copiez-collez exactement ce bloc dans chaque invite. Ne vous fiez jamais à la mémoire de l'IA ; la répétition explicite est le seul moyen de garantir la cohérence.

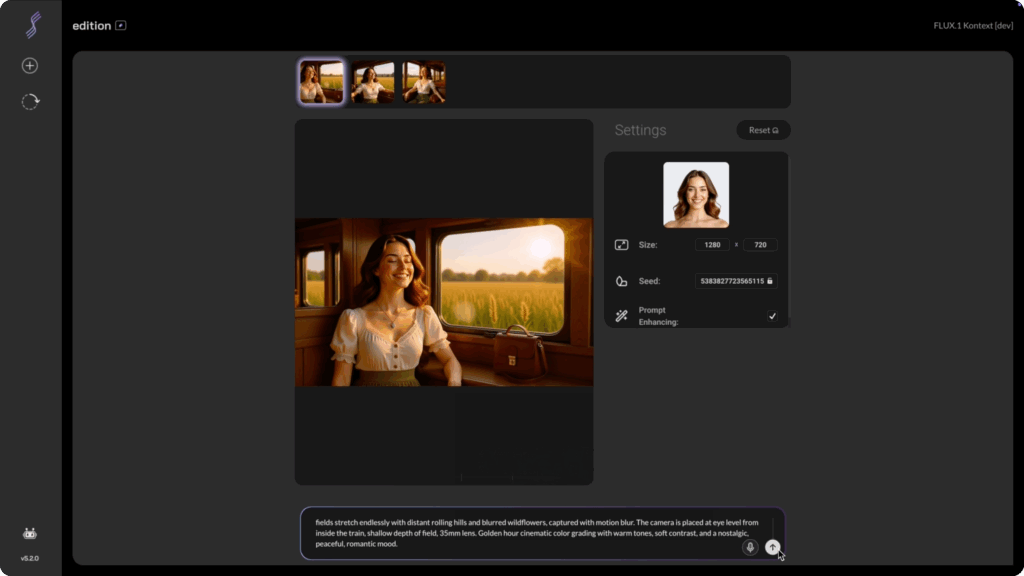

Étape 2 : Génération des « premières images » avec Flux Kontext

Avant de passer à l'animation, nous devons créer des images de référence haute fidélité. Ces « premières images » dictent le style visuel, la composition et la palette de couleurs de la vidéo.

L'outil : nous utilisons le modèle Flux Kontext dans le générateur d'images Full Stack AI.

Le processus : nous saisissons notre texte et téléchargeons une image de référence de notre personnage. Flux Kontext est particulièrement efficace pour préserver l'identité du personnage dans différents scénarios, en combinant l'action décrite dans le texte avec les caractéristiques de l'image de référence.

Avantage infrastructurel : fonctionnant sur des GPU Nvidia H200, les générations ne prennent que quelques secondes. Contrairement aux outils SaaS publics, la plateforme Full Stack AI n'utilise pas de « système de crédits ». Vous pouvez itérer 50 ou 100 fois jusqu'à ce que l'éclairage et la composition soient parfaits, sans vous soucier du coût par génération.

🦎 Conseil d'Iguana : générez par lots. Ne vous contentez pas de la première image. Même avec la meilleure invite, l'IA peut avoir du mal avec les petits détails comme l'alignement des mains ou des yeux. Générez des lots de 4 images à la fois. Choisissez celle qui présente la composition la plus nette et l'anatomie la plus correcte, car tout défaut dans l'image sera amplifié une fois animé.

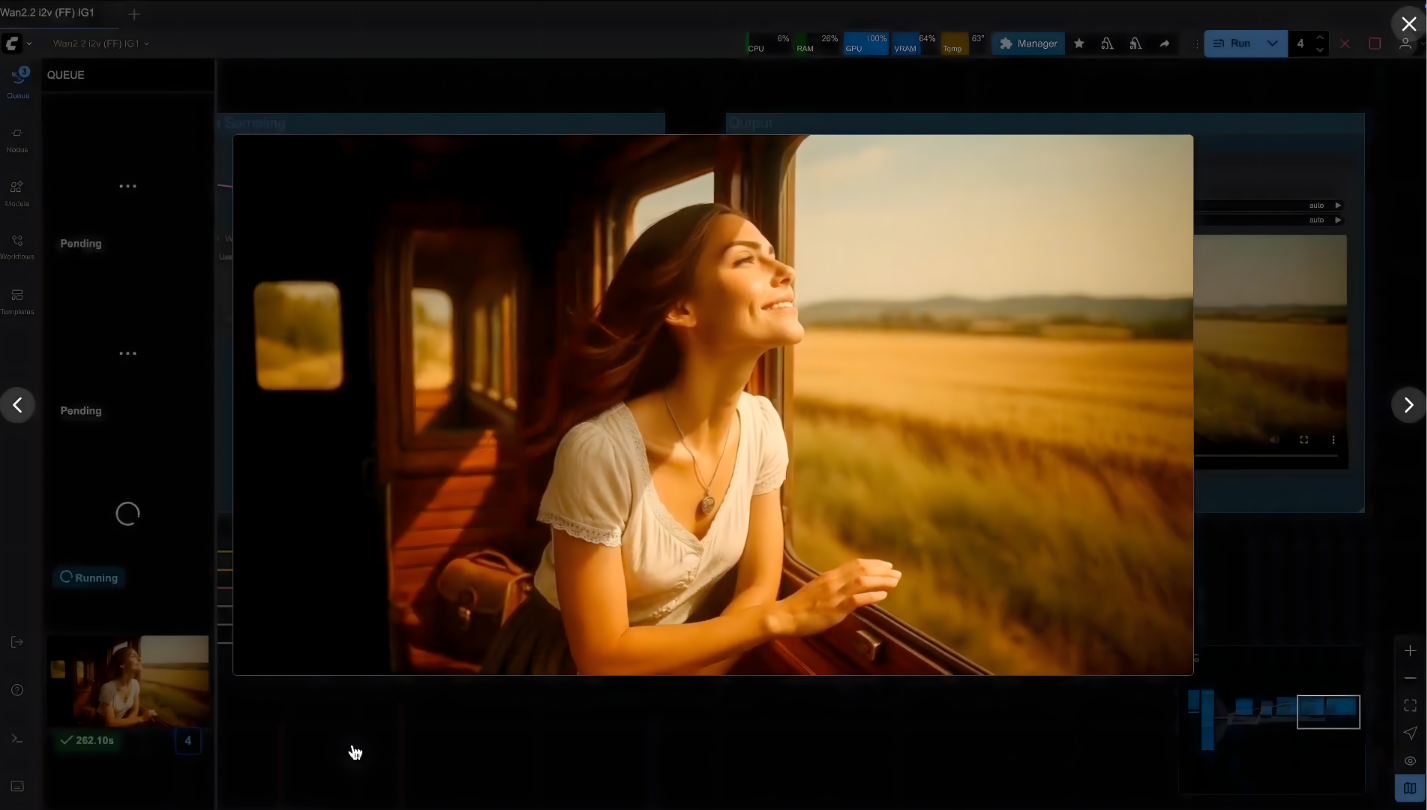

Étape 3 : Synthèse vidéo (ComfyUI et WAN 2.2)

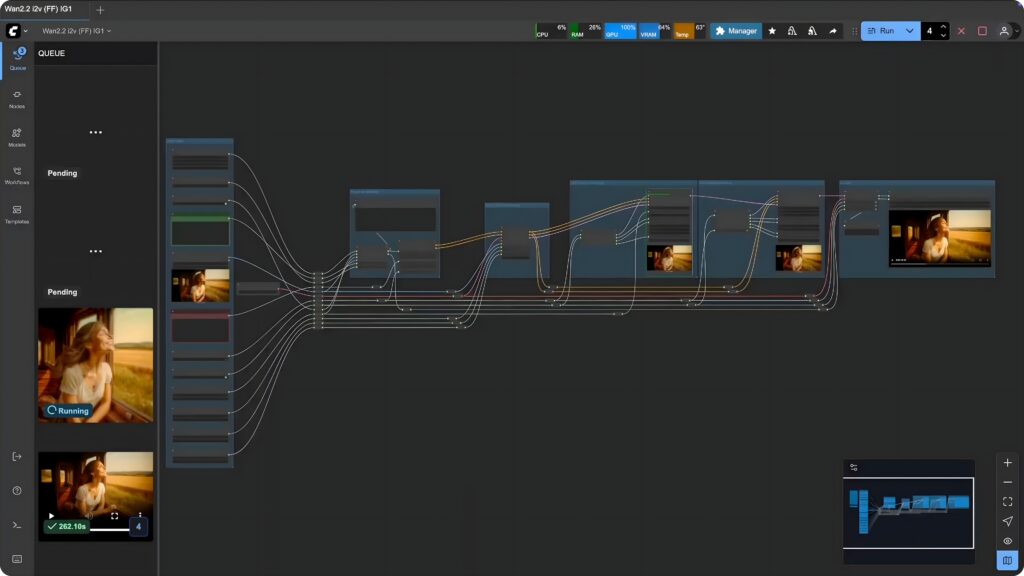

Une fois que nous avons nos images clés (premières images), nous passons à ComfyUI, l'interface basée sur des nœuds préinstallée sur la plateforme.

Le modèle : nous utilisons un modèle WAN 2.2 personnalisé conçu par notre équipe. WAN 2.2 est actuellement un modèle de pointe pour générer des mouvements réalistes et comprendre la physique.

Configuration :

Entrée : l'image « First Frame » + l'invite descriptive.

Fréquence d'images : WAN 2.2 offre les meilleures performances à 16 images par seconde.

Durée : pour obtenir un clip de 10 secondes, nous avons réglé la génération sur 161 images.

Exécution : nous lançons le rendu. La plateforme se charge du gros du travail, en traitant la cohérence temporelle nécessaire pour que le train se déplace et que le personnage salue naturellement.

🦎 Conseil Iguana : gardez les invites de mouvement simples. Lorsqu'il s'agit de vidéo, moins il y en a, mieux c'est. Au lieu de « Elle court, saute, puis danse », essayez « Zoom avant cinématographique lent, cheveux au vent ». ». Surcharger la consigne avec trop d'actions peut perturber le modèle et provoquer des artefacts (glitches). Laissez la « première image » définir la scène et la consigne guider l'atmosphère.

Étape 4 : Upscaling et interpolation d'images

Le résultat brut de l'étape 3 est une vidéo 720p à 16 images par seconde. Pour une diffusion cinématographique standard, cela est insuffisant. C'est à cette étape qu'une puissance de calcul élevée est indispensable.

Le flux de travail : nous chargeons un modèle ComfyUI secondaire dédié à la mise à l'échelle.

Résolution : l'IA reconstitue les détails manquants pour passer de 720p à 4K, en accentuant les contours et en affinant les textures.

Fluidité : simultanément, le système interpole les images pour passer de 16 à 60 images par seconde, éliminant ainsi l'aspect saccadé des vidéos brutes générées par l'IA.

Performances : ce processus est très gourmand en ressources informatiques. Sur un GPU grand public standard, cela peut prendre plusieurs heures. Sur le cluster H200 de la plateforme Full Stack AI, l'inférence à grande vitesse fournit un résultat précis et fluide en quelques minutes.

🦎 Conseil Iguana : ne sur-accentuez pas la netteté. Dans les paramètres d'amélioration, évitez de maximiser la puissance du « débruitage » ou de la « netteté ». Une netteté excessive peut donner à la vidéo un aspect « granuleux » et artificiel. Visez une valeur comprise entre 0,3 et 0,5 afin de conserver un grain cinématographique et une douceur naturelle.

Étape 5 : Post-production finale

La dernière étape comble le fossé entre la génération par IA et la réalisation cinématographique traditionnelle.

-

Montage : nous assemblons les clips à l'aide d'un logiciel de montage standard (tel que Premiere Pro ou DaVinci Resolve).

-

Étalonnage des couleurs : nous appliquons un étalonnage afin d'unifier les tons des différents clips générés par l'IA, leur conférant ainsi une ambiance cohérente.

-

Remappage temporel : grâce à la conversion à 60 images par seconde, nous pouvons appliquer des effets de ralenti fluides (ralentissement à 50 % de la vitesse) pour créer une atmosphère onirique sans saccades.

🦎 Conseil d'Iguana : le son représente 50 % de la magie. Les vidéos générées par l'IA sont souvent muettes. Pour renforcer le réalisme, superposez plusieurs couches audio : ajoutez une piste d'ambiance (vent, grondement de train), des effets sonores spécifiques (bruissement de tissu, chant d'oiseaux) et une musique émouvante. Une conception sonore de qualité peut transformer un simple clip généré par l'IA en un film à succès.

Pourquoi les infrastructures sont importantes pour l'IA vidéo

Ce que vous avez vu n'est pas seulement un exploit créatif, c'est aussi une prouesse en matière d'infrastructure.

En 2025, le frein à l'entrée n'est pas la créativité, mais la puissance de calcul. L'exécution de workflows complexes combinant Flux et WAN 2.2 nécessite un environnement privé, sécurisé et incroyablement rapide.

La plateforme Full Stack AI offre exactement cela : un GenAI privé qui permet aux entreprises et aux créateurs de produire des ressources illimitées de qualité professionnelle sans les contraintes des clouds publics ou du matériel grand public.

Prêt à déployer votre propre GenAI privé ? Découvrez comment Iguane Solutions peut optimiser vos workflows créatifs grâce à des clusters GPU haute performance.

Découvrez les solutions d'IA Full Stack : genai

👉 Retrouvez toutes les vidéos de nos événements et les témoignages de nos clients sur notre chaîne YouTube.